近日我校多篇論文被人工智能與計算機視覺領域的CCF A類頂級會議CVPR 2023錄用,彰顯了我校在科研和學生學術創新能力培養方面的成效。

顏成鋼教授團隊以杭電為第一單位的論文“Gaussian Label Distribution Learning for Spherical Object Detection”被計算機視覺領域的CCF A類頂級會議CVPR 2023主會(main conference)接收,該論文的合作單位有中國科學院計算技術研究所。論文第一作者是我校“智能信息處理實驗室”(HDU IIPLab)的博士研究生徐杭。

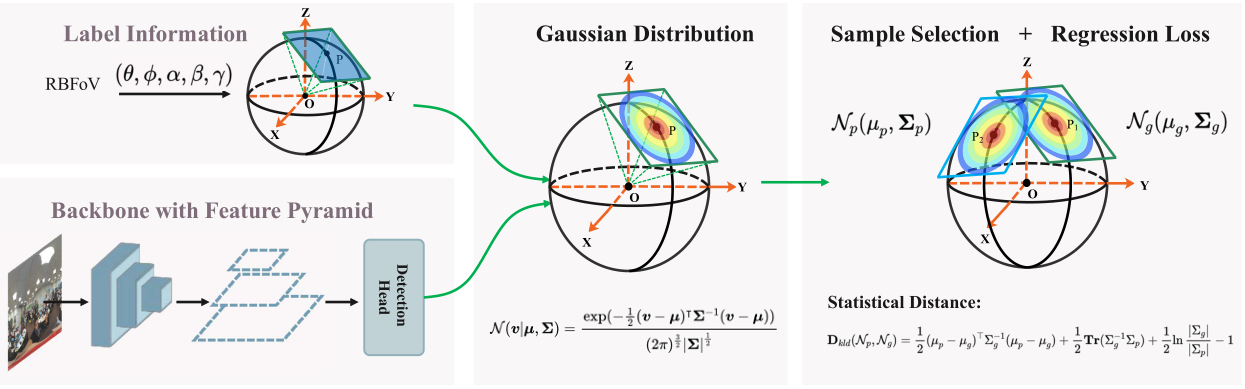

全景視覺數據是通過全景數據采集設備采集得到的全景圖像或全景視頻,它包含了空間中全方位360度的視覺信息,具有“視野全、可交互、沉浸感強”的特點。這使得其在很多領域都得到了很好的應用,如虛擬現實、機器人、視頻監控等。本研究工作專注于全景視覺目標檢測領域,提出了一種簡單有效的回歸損失函數來提升全景視覺目標檢測算法的性能。具體來說,在訓練階段,首先將預測的球面矩形框和真實的球面矩形框的切面轉換成高斯分布。然后,使用K-L散度來度量兩個分布之間的距離。在測試階段,直接從已訓練模型中獲得球形包圍框的輸出,因此網絡的推理時間保持不變。整個方法的框架如下所示:

圖1 訓練模型框架

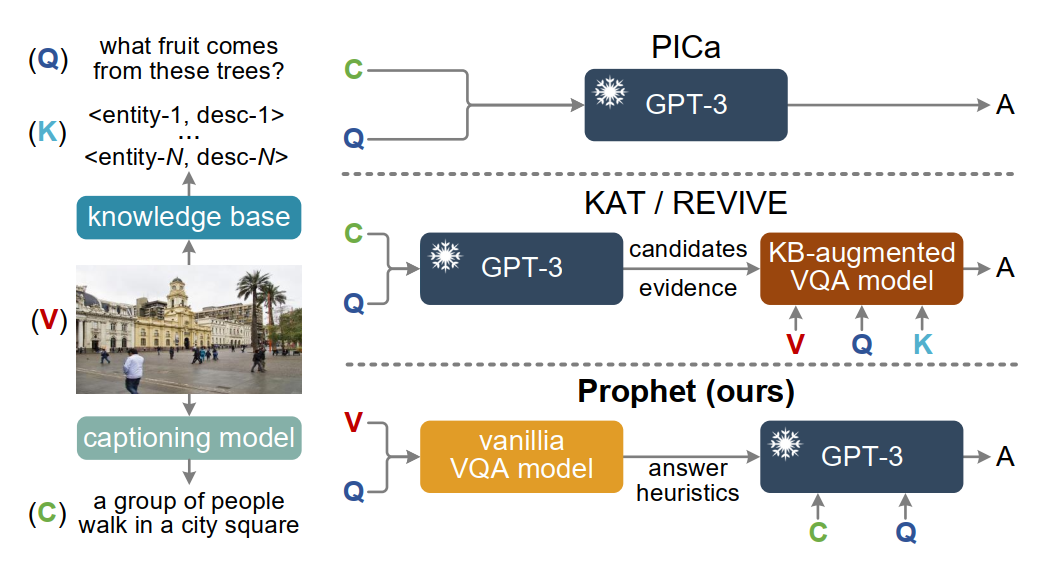

論文“Prompting Large Language Models with Answer Heuristics for Knowledge-based Visual Question Answering”研究了如何利用“外部知識”進行跨媒體推理的挑戰性問題。GPT-3、ChatGPT等大規模語言模型內部蘊含了豐富的知識,如何將其作為隱式知識庫來進行推理是跨媒體研究的挑戰性問題。本文提出的Prophet方法提出一種 “答案啟發”的通用跨媒體推理框架,通過在大模型上游引入一個可學習的任務相關視覺問答小模型,來更好地激發大模型的潛力。該論文第一作者為媒體智能實驗室碩士研究生邵鎮煒同學,通訊作者為計算機學院余宙教授。邵鎮煒同學患有“進行性脊肌萎縮癥”,肢體一級殘疾,沒有生活自理能力,生活和學習需要母親全程照顧。他常年堅持與病魔抗爭,同輪椅為伴,克服因身體缺陷帶來的種種不便,并努力追求卓越。2017年以644分的成績被杭州電子科技大學計算機科學與技術專業錄取,大學期間獲得2018年中國大學生自強之星、2020年度國家獎學金和浙江省優秀畢業生等榮譽。2021年通過研究生推免的方式加入媒體智能實驗室攻讀碩士研究生。

圖2 通用跨媒體推理框架

論文 "Masked and Adaptive Transformer for Exemplar Based Image Translation"提出了一種新穎的基于示例的圖像翻譯框架,主要關注跨域間建立準確的語義對應關系,以學得示例風格圖像生成。該工作提出了 “masked and adaptive transformer” 結構來學習對應關系以執行上下文感知的特征增強。在對比學習約束和全局風格注入的引導下,可生成高質量風格圖像。該論文第一作者為計算機學院智能可視建模與仿真實驗室(iGame-Lab)2021級碩士研究生蔣暢,通訊作者為高飛副教授,論文的合作者包括碩士生馬彪、林裕浩,西安電子科技大學王楠楠教授和杭電iGame實驗室負責人徐崗教授。

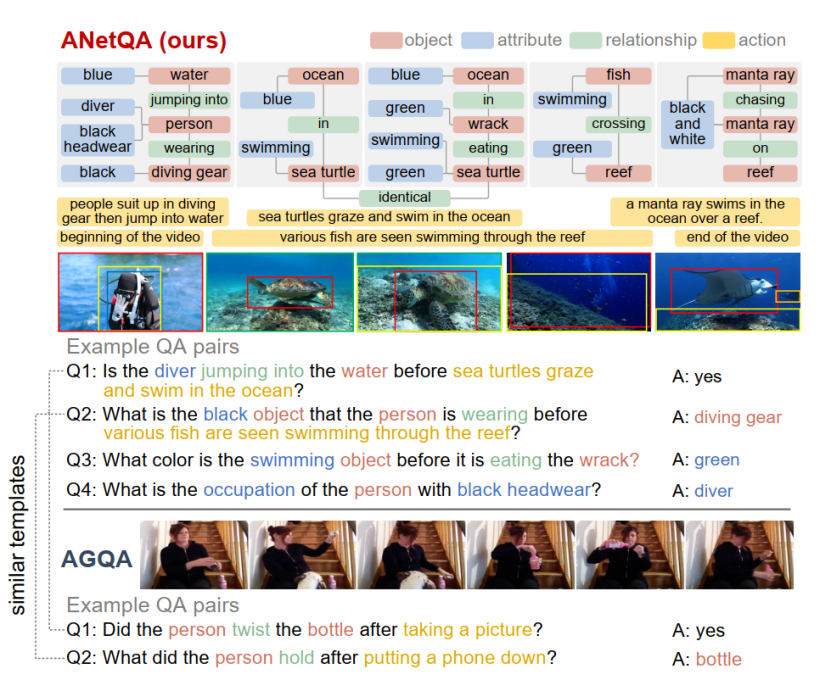

論文"ANetQA: A Large-scale Benchmark for Fine-grained Compositional Reasoning over Untrimmed Videos"構建了目前最大的面向復雜長視頻的問答數據集,通過人工標注“細粒度”視頻場景圖,在1萬個長視頻上自動生成了14億問答樣本,過濾平衡后最終形成1300萬樣本,比現有最大的視頻問答數據集(斯坦福大學的AGQA)大一個數量級,在問答細粒度方面優勢明顯。論文第一作者為余宙教授,通訊作者為俞俊教授,碩士研究生鄭力祥同學參與了本文的主要工作。

圖3 ANetQA框架

圖4 Masked and Adaptive Transformer圖像翻譯效果圖

論文“Trajectory-Aware Body Interaction Transformer for Multi-Person Pose Forecasting”以多人動作預測為研究方向。該論文為人文藝術與數字媒體學院智能媒體計算研究所最新研究成果,論文第一作者為碩士生彭小剛,第二作者為碩士生毛思遠,通訊作者為吳子朝副教授。多人三維人體姿態(運動)預測在計算機視覺和人工智能領域都有著巨大的應用價值,例如人機交互,無人駕駛,智能監控和虛擬現實等,其解決的任務是根據觀察到的一段運動序列去盡可能準確地預測未來的姿態變化和運動軌跡。現有的大部分研究方法基本都基于單人姿態預測,沒有考慮人與人之間的復雜交互影響,如下圖5所示。此外基于單人預測的方法主要關注如何建模人體的局部姿態運動而忽略了在三維環境中的全局位置變化。近年來,雖然逐漸出現了一些多人姿態預測的工作來解決上述問題,但這些方法只簡單將人體姿態序列表征成時序序列來建模人體之間的運動相關性,沒有更加細粒度地去建模人體之間的身體部位交互。

圖5. (a) 復雜場景下的多人運動交互,其交互程度有高有低。(b) 關于身體部位交互的建模思路。

因此,研究團隊提出一個基于軌跡感知的身體互動Transformer模型去有效建模多人之間的身體部位互動。為了給Transfomer模型輸入更有效的數據,我們先引入一個時序部位劃分模塊,將每個人的姿態運動序列按照身體部位進行劃分并把所有人劃分好的序列拼接成一個整體,稱作多人身體部位序列(MPBP) 。 該序列包括了多人的時序和身體部位信息。 我們的方法在相關數據集的短期 (0.2 —1.0s) 和長期 (1.0—3.0s) 預測任務上都表現出最佳的性能。

CVPR(Computer Vision and Pattern Recognition)是人工智能與計算機視覺領域最高級別的國際頂級學術會議,也是中國計算機學會(CCF)推薦的A類國際學術會議,每年六月召開一次。會議于6月18日-22日在加拿大溫哥華召開,今年CVPR共收到了創紀錄的9155篇投稿論文,錄用2360篇論文,錄用率約為25.78%。