近日,ACM International Conference on Multimedia (簡(jiǎn)稱ACM MM)公布了論文的收錄結(jié)果,杭州電子科技大學(xué)計(jì)算機(jī)學(xué)院浙江省腦機(jī)協(xié)同智能重點(diǎn)實(shí)驗(yàn)室以杭電為第一單位的論文被ACM MM(CCF A類會(huì)議)錄用。論文第一作者是2020級(jí)碩士研究生郭繼偉,論文的合作者還有唐佳佳博士,戴瑋辰副研究員和網(wǎng)易伏羲人工智能實(shí)驗(yàn)室的丁彧博士,指導(dǎo)老師孔萬(wàn)增教授為通訊作者。ACM是世界上最大的計(jì)算機(jī)領(lǐng)域?qū)I(yè)性學(xué)術(shù)組織,其評(píng)選的圖靈獎(jiǎng)(A.M. Turing Award)被公認(rèn)為世界計(jì)算機(jī)領(lǐng)域的諾貝爾獎(jiǎng)。而ACM MM被認(rèn)為是多媒體技術(shù)領(lǐng)域奧運(yùn)級(jí)別的頂級(jí)盛會(huì),各類機(jī)構(gòu)都將在會(huì)議上分享、交流最新研究成果。本屆大會(huì)的有效投稿量達(dá)2473篇,接收論文690篇,接收率約為27.9%。

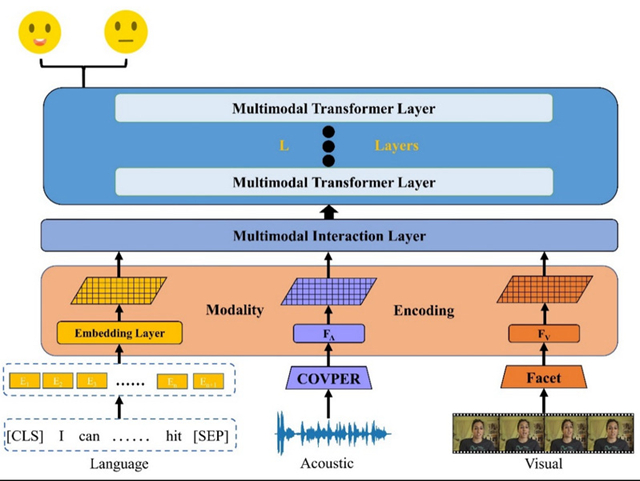

論文Dynamically Adjust Word Representations Using Unaligned Multimodal Information提出一種端到端的多模態(tài)情感分析方法。創(chuàng)新性的利用未對(duì)齊的非語(yǔ)言行為信息,在整個(gè)話語(yǔ)尺度范圍內(nèi)動(dòng)態(tài)調(diào)整人類語(yǔ)言的表示從而完成多模態(tài)情感分析任務(wù)。相比較于利用對(duì)齊的行為信息的工作,未對(duì)齊的行為信息不需要手動(dòng)的對(duì)多模態(tài)信號(hào)進(jìn)行預(yù)處理,同時(shí)也能夠?qū)Χ嗄B(tài)信息中存在的長(zhǎng)距離依賴關(guān)系有效建模。本文的方法在CMU-MOSI和CMU-MOSEI兩個(gè)公開的多模態(tài)情感分析數(shù)據(jù)集上取得了顯著提升。